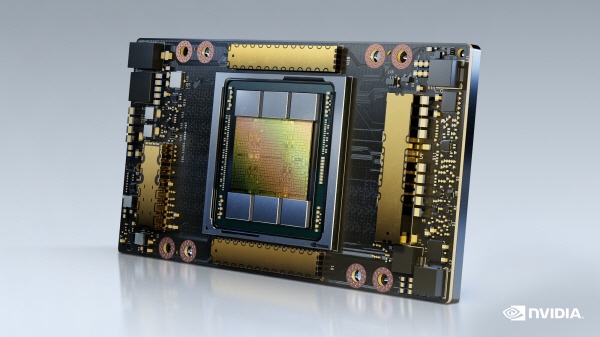

[디지털경제뉴스 박시현 기자] 엔비디아가 인공지능(AI) 슈퍼컴퓨팅 GPU ‘A100 80GB GPU’를 공개했다.

HBM2e 기술이 적용된 ‘A100 80GB GPU’는 A100 40GB GPU의 고대역폭 메모리를 2배인 80GB로 늘리고, 초당 2테라바이트(TB) 이상의 메모리 대역폭을 제공한다. 이를 통해 세계에서 가장 빠른 데이터센터 GPU인 A100에 데이터를 신속하게 공급해 연구자들이 애플리케이션을 더욱 빠르게 가속화하고, 대규모의 모델 및 데이터셋을 활용할 수 있도록 한다.

아토스, 델 테크놀로지스, 후지쯔, 기가바이트, HPE, 인스퍼, 레노버, 퀀타, 슈퍼마이크로는 2021년 상반기에 A100 80GB GPU가 탑재된 시스템을 제공할 계획이다.

새로운 A100 80GB GPU는 40GB 버전의 다양한 기능을 기반으로 설계됐으며, 막대한 데이터 메모리를 요구하는 광범위한 애플리케이션에 이상적이다.

AI 훈련에 있어 DLRM과 같은 추천 시스템 모델에는 수십억 명의 사용자와 수십억 개의 제품을 나타내는 방대한 테이블을 포함하고 있다. A100 80GB GPU는 최대 3배 빠른 속도를 제공하므로 기업은 이러한 유형의 모델을 신속하게 재훈련해 매우 정확한 추천 서비스를 제공할 수 있다.

A100 80GB GPU는 뛰어난 언어 생성 기능을 갖춘 GPT-2 자연어 처리 모델과 같이 단일 HGX 탑재 서버에서 더 많은 매개변수를 가진 방대한 모델을 훈련할 수 있다. 이를 통해 구현에 많은 시간이 소요되고, 여러 노드에서 느리게 실행될 수 있는 데이터 혹은 모델을 위한 병렬처리 아키텍처의 필요성을 없앤다.

A100은 멀티 인스턴스 GPU(MIG) 기술을 통해 최대 7개의 GPU 인스턴스로 분할할 수 있으며, 각각의 인스턴스는 10GB 메모리를 갖는다. 해당 기술은 안전한 하드웨어 격리를 제공하고, 다양한 소규모 워크로드를 위해 GPU 활용도를 극대화한다. RNN-T와 같은 자동 음성 모델의 AI 추론의 경우, 단일 A100 80GB MIG 인스턴스가 훨씬 더 큰 배치 사이즈를 작업해 1.25배 더 많은 추론 처리량을 제공한다.

TB 규모의 리테일용 빅데이터 분석 벤치마크에서 A100 80GB GPU는 최대 2배로 높은 성능을 달성하며, 가장 큰 데이터셋에서 신속한 통찰력을 제공하는 이상적인 플랫폼임을 입증했다. 이를 통해, 기업들은 동적으로 데이터가 업데이트됨에 따라 실시간으로 주요 의사결정을 내릴 수 있다.

A100 80GB GPU는 기상 예측과 양자 화학 등의 과학 애플리케이션을 빠르게 가속화할 수 있다. 소재 시뮬레이션인 퀀텀 에스프레소(Quantum Espresso)는 A100 80GB GPU의 단일 노드로 성능을 2배 가까이 향상시켰다.